Oleh: Choirun Nisa, S.ST., M.Tr.Kom

- Pendahuluan

Perkembangan teknologi kecerdasan buatan (Artificial Intelligence/AI) dalam beberapa tahun terakhir telah menghasilkan berbagai inovasi dalam bidang pemrosesan citra digital, khususnya pada aplikasi yang mampu memanipulasi wajah manusia secara otomatis. Aplikasi seperti FaceApp, Lensa AI, dan Reface menjadi populer di kalangan masyarakat karena kemampuannya mengubah wajah menjadi lebih tua, lebih muda, bergaya kartun, atau bahkan menambahkan ekspresi tertentu dengan hasil yang tampak realistis (Guan et al., 2020). Teknologi ini umumnya didukung oleh pendekatan deep learning yang kompleks, seperti penggunaan Convolutional Neural Networks (CNN) dan Generative Adversarial Networks (GANs), yang memungkinkan sistem mengenali dan memodifikasi wajah secara akurat dan cepat (Goodfellow et al., 2014).

Namun di balik kemudahan dan kesenangan yang ditawarkan, terdapat isu serius terkait privasi dan keamanan data pengguna. Manipulasi citra wajah bukan sekadar persoalan estetika, melainkan menyangkut data biometrik yang bersifat unik dan sensitif. Ketika pengguna mengunggah foto wajah ke dalam aplikasi, data tersebut umumnya diproses di server cloud milik penyedia layanan. Hal ini menimbulkan kekhawatiran terhadap potensi penyalahgunaan data, mulai dari penyimpanan tanpa izin, penggunaan ulang untuk pelatihan algoritma, hingga kemungkinan dijadikan bahan dasar untuk membuat konten palsu seperti deepfake (Kietzmann et al., 2018).

Dalam konteks ini, wajah bukan lagi sekadar bagian dari identitas visual, tetapi telah menjadi aset digital yang dapat digunakan untuk berbagai tujuan, baik yang etis maupun yang merugikan. Sayangnya, kesadaran masyarakat akan risiko ini masih tergolong rendah, sementara regulasi perlindungan data biometrik juga belum sepenuhnya mampu mengantisipasi dampak dari kemajuan teknologi AI tersebut (Zhao et al., 2020). Oleh karena itu, kajian mendalam mengenai potensi risiko privasi dan keamanan dari penggunaan teknologi AI dalam manipulasi citra wajah menjadi sangat penting.

Artikel ini bertujuan untuk menganalisis secara komprehensif risiko-risiko yang mungkin timbul dari fenomena tersebut, dengan mengkaji aspek teknologis, hukum, etika, serta memberikan rekomendasi strategis bagi berbagai pihak yang terlibat, termasuk pengguna, pengembang aplikasi, dan pembuat kebijakan.

2. Dasar Teknologi yang Digunakan

Teknologi yang digunakan dalam aplikasi manipulasi citra wajah berbasis kecerdasan buatan (AI) sering kali melibatkan algoritma deep learning, terutama Convolutional Neural Networks (CNNs) dan Generative Adversarial Networks (GANs). Kedua metode ini memungkinkan sistem untuk mengenali dan menghasilkan citra yang sangat realistis, bahkan dalam kasus perubahan wajah yang cukup ekstrim.

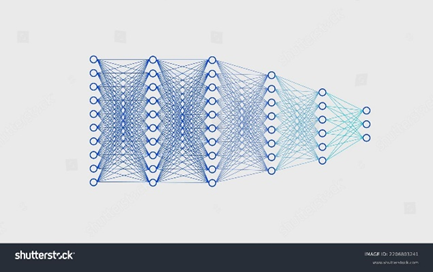

2.1. Convolutional Neural Networks (CNNs)

CNN adalah jenis jaringan saraf tiruan yang paling sering digunakan dalam pengolahan gambar. Dalam konteks aplikasi manipulasi wajah, CNN digunakan untuk mendeteksi dan mengenali fitur wajah, seperti mata, hidung, mulut, dan bentuk wajah secara keseluruhan. CNN bekerja dengan mengonvolusi data gambar melalui beberapa lapisan (layer), yang masing-masing mengekstraksi fitur-fitur penting yang kemudian digunakan untuk pengenalan pola.

Sebagai contoh, ketika sebuah foto diunggah ke aplikasi, CNN akan memindai gambar tersebut dan mengidentifikasi elemen-elemen wajah, seperti garis rahang atau bentuk mata. Dengan algoritma yang telah dilatih menggunakan ribuan atau bahkan jutaan data wajah, model ini mampu memahami variasi dari fitur wajah dan mengubahnya sesuai dengan perintah pengguna (LeCun et al., 2015).

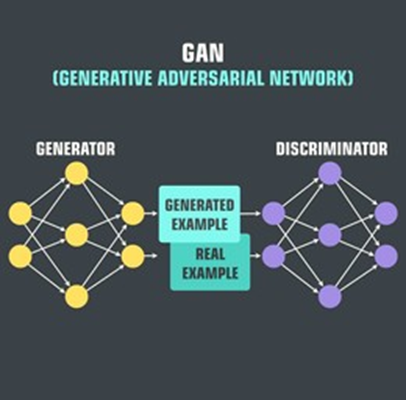

2.2. Generative Adversarial Networks (GANs)

Sementara CNN lebih fokus pada pengenalan wajah, Generative Adversarial Networks (GANs) berperan dalam generasi gambar baru berdasarkan data yang ada. GAN terdiri dari dua model utama: generator dan discriminator. Generator bertugas untuk membuat gambar baru, sementara discriminator menilai apakah gambar yang dihasilkan cukup realistis atau tidak. Kedua model ini saling bersaing, sehingga GAN secara terus-menerus meningkatkan kualitas gambar yang dihasilkan hingga mencapai tingkat yang sangat tinggi.

Dalam konteks aplikasi manipulasi wajah, GAN digunakan untuk menghasilkan perubahan yang diinginkan pada wajah, seperti mengubah ekspresi atau menciptakan tampilan wajah yang lebih muda atau lebih tua. Karena GAN dapat belajar dari data besar, gambar yang dihasilkan bisa sangat mirip dengan gambar asli, bahkan saat dilakukan perubahan yang sangat signifikan (Goodfellow et al., 2014).

2.3. Proses Pengolahan Citra

Setelah gambar diunggah, aplikasi akan mengolah data tersebut melalui berbagai tahapan. Pertama, aplikasi akan mendeteksi wajah dalam gambar menggunakan teknik deteksi wajah seperti Haar Cascades atau MTCNN (Multi-task Cascaded Convolutional Networks). Proses ini memungkinkan sistem untuk mengetahui lokasi dan ukuran wajah dalam gambar, yang menjadi titik awal untuk manipulasi lebih lanjut.

Selanjutnya, dengan menggunakan model AI yang telah dilatih, aplikasi akan mengubah elemen wajah yang diinginkan, apakah itu mengubah ekspresi wajah, usia, atau bahkan menambah elemen-elemen lain yang tidak ada dalam gambar asli. Hasil akhirnya adalah citra yang terlihat sangat alami, meskipun telah mengalami perubahan yang signifikan.

2.4. Penyimpanan dan Pemrosesan Data

Meskipun proses manipulasi wajah dilakukan dengan algoritma yang kuat dan canggih, ada satu aspek yang sering kali terlupakan: penyimpanan data. Banyak aplikasi memproses gambar di server cloud, yang memungkinkan pengguna untuk mengakses hasilnya di berbagai perangkat. Hal ini menimbulkan risiko terkait dengan bagaimana data tersebut disimpan dan digunakan kembali.

Bergantung pada kebijakan aplikasi, foto wajah yang diunggah oleh pengguna dapat disimpan dalam jangka panjang dan digunakan untuk tujuan lain, seperti melatih model AI agar lebih akurat atau bahkan dijual kepada pihak ketiga. Proses ini sering kali tidak jelas dalam syarat dan ketentuan aplikasi, dan banyak pengguna yang tidak menyadari bahwa gambar mereka dapat digunakan di luar tujuan yang mereka inginkan (Zhao et al., 2020).

3. Risiko Privasi

Penggunaan aplikasi manipulasi citra wajah berbasis AI menghadirkan berbagai potensi risiko terhadap privasi penggunanya. Salah satu risiko utama adalah bagaimana data wajah, yang merupakan informasi biometrik yang sangat sensitif, diperlakukan setelah diunggah ke server aplikasi. Tanpa adanya pemahaman yang jelas dari pengguna tentang bagaimana data mereka digunakan, risiko kebocoran data pribadi, serta penyalahgunaan informasi pribadi menjadi sangat nyata.

3.1. Pengumpulan Data Tanpa Persetujuan yang Jelas

Sebagian besar aplikasi manipulasi wajah mengharuskan pengguna untuk mengunggah foto wajah mereka untuk dapat menggunakan fitur-fitur yang ditawarkan. Namun, tidak semua aplikasi secara eksplisit meminta izin pengguna untuk menyimpan atau menggunakan data tersebut setelah foto diunggah. Sering kali, kebijakan privasi aplikasi yang ada tidak cukup jelas atau transparan dalam menjelaskan bagaimana data wajah akan digunakan, disimpan, atau dibagikan kepada pihak ketiga.

Menurut penelitian oleh Zhao et al. (2020), banyak aplikasi mengumpulkan data pengguna tanpa memberikan pemberitahuan yang memadai atau tanpa mendapatkan persetujuan eksplisit yang dibutuhkan. Dalam beberapa kasus, aplikasi bahkan memiliki klausa yang memungkinkan mereka untuk mengakses foto dan data lainnya di luar foto yang diunggah untuk manipulasi wajah, seperti metadata gambar atau informasi lokasi.

3.2. Penyimpanan dan Penggunaan Ulang Data

Setelah gambar diunggah, data tersebut biasanya diproses di server yang dikelola oleh pihak ketiga. Salah satu masalah utama terkait dengan penyimpanan data wajah adalah bagaimana gambar tersebut dapat disimpan dalam waktu yang lama, meskipun mungkin sudah tidak lagi digunakan dalam proses manipulasi wajah. Dalam banyak kasus, penyimpanan data tidak dibatasi oleh waktu tertentu dan foto yang diunggah dapat disimpan tanpa batas waktu yang jelas. Selain itu, data tersebut dapat digunakan untuk melatih model AI yang lebih kuat, tanpa adanya kontrol dari pengguna atas bagaimana data mereka digunakan (Zhao et al., 2020).

Pada beberapa aplikasi, data wajah yang dikumpulkan dapat digunakan untuk tujuan yang lebih luas, seperti meningkatkan algoritma AI atau bahkan dijual kepada pihak ketiga yang ingin menggunakan data untuk penelitian pasar atau pengembangan teknologi. Dengan demikian, wajah pengguna yang pada awalnya dianggap sebagai data pribadi bisa berubah menjadi aset yang diperdagangkan, meningkatkan risiko privasi yang signifikan.

3.3. Potensi Kebocoran Data

Kebocoran data merupakan salah satu ancaman terbesar terhadap privasi dalam penggunaan aplikasi yang memanipulasi wajah. Data biometrik seperti wajah memiliki potensi untuk digunakan oleh pihak yang tidak berwenang, dan dalam hal ini, wajah adalah kunci untuk mengakses data lainnya. Penyalahgunaan atau kebocoran data wajah bisa menyebabkan pencurian identitas dan penyalahgunaan lain yang lebih luas.

Bahkan jika aplikasi tersebut memiliki kebijakan yang ketat mengenai perlindungan data, risiko kebocoran tetap ada, terutama jika data tersebut disimpan dalam jumlah besar di server pihak ketiga yang rentan terhadap serangan siber. Kasus kebocoran data dari berbagai layanan cloud telah terjadi di masa lalu, yang mengakibatkan data pribadi pengguna tersebar di internet. Hal ini memperburuk kekhawatiran bahwa data wajah, yang seharusnya bersifat pribadi dan tidak bisa diganti, dapat jatuh ke tangan yang salah dan digunakan untuk tujuan yang merugikan (Kietzmann et al., 2018).

3.4. Penyalahgunaan Teknologi untuk Penciptaan Deepfake

Selain potensi kebocoran data, teknologi manipulasi wajah berbasis AI juga dapat disalahgunakan untuk membuat deepfake, yakni video atau gambar palsu yang sangat realistis yang menampilkan seseorang dalam situasi atau konteks yang sebenarnya tidak pernah terjadi. Deepfake bisa digunakan untuk penipuan, pemerasan, atau bahkan untuk tujuan politik yang merugikan.

Teknologi deepfake dapat meniru wajah seseorang dengan sangat presisi, sehingga sulit bagi orang lain untuk membedakan antara gambar asli dan yang telah dimanipulasi. Ini merupakan potensi besar yang bisa dimanfaatkan oleh pihak yang berniat jahat untuk menyebarkan disinformasi atau melakukan pencemaran nama baik. Misalnya, seseorang dapat menggunakan gambar atau video yang dimanipulasi untuk membuat individu tampak terlibat dalam aktivitas kriminal atau perilaku yang tidak sesuai dengan kenyataan, yang dapat merusak reputasi atau karier mereka secara permanen (Kietzmann et al., 2018).

4. Risiko Keamanan Data Biometrik

Selain risiko terkait privasi, penggunaan teknologi AI untuk manipulasi citra wajah juga menimbulkan berbagai ancaman terhadap keamanan data biometrik yang sangat sensitif. Data wajah, yang termasuk dalam kategori biometrik, bersifat unik dan tidak dapat diganti seperti kata sandi atau nomor identitas. Oleh karena itu, perlindungan yang memadai terhadap data wajah sangat penting untuk mencegah potensi penyalahgunaan dan serangan siber yang lebih serius.

4.1. Kerentanannya terhadap Serangan Siber

Data biometrik, terutama gambar wajah, sangat berisiko menjadi sasaran serangan siber. Gambar wajah yang telah diunggah dan disimpan di server cloud dapat diakses oleh pihak yang tidak berwenang jika tidak dilindungi dengan sistem keamanan yang cukup kuat. Serangan seperti data breach atau pencurian data dapat mengakibatkan kebocoran informasi biometrik pribadi yang sangat berharga.

Dalam beberapa tahun terakhir, serangan terhadap sistem penyimpanan cloud dan database besar yang menyimpan data sensitif telah meningkat. Misalnya, dalam kasus kebocoran data yang melibatkan platform-platform besar, gambar wajah pengguna sering kali menjadi target karena data tersebut dapat digunakan untuk tujuan pencurian identitas atau bahkan untuk meniru identitas seseorang secara digital. Tanpa lapisan keamanan yang memadai, data biometrik yang tersimpan dalam jumlah besar dapat menjadi sumber daya yang sangat bernilai bagi para peretas (Kietzmann et al., 2018).

4.2. Tidak Dapat Diganti atau Diperbarui

Keunikan dan ketidakmampuan untuk mengganti data wajah menjadikan data biometrik lebih rentan terhadap penyalahgunaan. Jika gambar wajah pengguna jatuh ke tangan yang salah, tidak ada cara untuk “mengubah” atau “reset” wajah tersebut, seperti halnya dengan kata sandi atau nomor identitas lainnya. Ini berbeda dengan data tradisional, seperti kata sandi atau PIN, yang dapat diubah setiap kali terjadi pelanggaran.

Misalnya, dalam kasus pencurian identitas, seseorang yang memiliki akses ke data biometrik wajah seseorang dapat dengan mudah membuat deepfake yang sangat realistis atau menggunakan gambar wajah untuk berbagai jenis penipuan lainnya. Oleh karena itu, meskipun teknologi AI memungkinkan manipulasi wajah yang luar biasa, ia juga membuka potensi besar bagi penyalahgunaan data wajah yang sangat sulit untuk dikendalikan dan diubah (Zhao et al., 2020).

4.3. Penggunaan Data Biometrik untuk Pemantauan Tanpa Izin

Teknologi pemrosesan citra wajah berbasis AI, yang dapat mengenali dan menganalisis wajah dalam waktu nyata, telah digunakan dalam berbagai aplikasi pengawasan, mulai dari pemantauan keamanan hingga pemasaran yang dipersonalisasi. Namun, hal ini menimbulkan masalah terkait dengan pemantauan tanpa izin atau surveillance yang dilakukan oleh entitas komersial atau bahkan pemerintah.

Ketika wajah seseorang dapat dikenali di berbagai tempat menggunakan teknologi AI, hal ini dapat menyebabkan pelanggaran privasi yang serius. Misalnya, kamera pengawas yang dilengkapi dengan teknologi AI dapat memindai wajah orang tanpa sepengetahuan atau persetujuan mereka. Bahkan, data biometrik yang dikumpulkan dapat digunakan untuk melacak gerakan individu secara real-time, membuka potensi untuk pengawasan yang tidak sah dan melanggar hak privasi individu (Zhao et al., 2020). Ini dapat memicu masalah etis dan hukum, terutama jika digunakan tanpa regulasi yang ketat.

4.4. Potensi Penyalahgunaan oleh Pihak Ketiga

Selain ancaman yang ditimbulkan oleh pihak yang melakukan serangan siber, data biometrik yang diunggah juga berpotensi disalahgunakan oleh pihak ketiga, seperti pengiklan atau perusahaan yang mengumpulkan data untuk tujuan komersial. Dalam beberapa kasus, aplikasi manipulasi wajah mungkin membagikan atau menjual data biometrik yang mereka kumpulkan kepada perusahaan pemasaran atau penyedia layanan lainnya.

Misalnya, foto wajah yang diunggah untuk mengubah ekspresi atau usia mungkin digunakan oleh perusahaan untuk melatih algoritma lain dalam mengenali pola perilaku konsumen atau menciptakan iklan yang lebih personal. Jika tidak ada pengawasan yang ketat, data biometrik tersebut dapat dieksploitasi untuk keuntungan finansial tanpa persetujuan eksplisit dari pengguna, yang menambah lapisan risiko terhadap keamanan data pribadi (Kietzmann et al., 2018).

5. Rekomendasi Perlindungan dan Solusi

Untuk mengurangi risiko yang ditimbulkan oleh penggunaan teknologi AI dalam manipulasi citra wajah, penting bagi pengguna, pengembang aplikasi, serta pembuat kebijakan untuk bekerja sama dalam menciptakan ekosistem yang lebih aman dan transparan. Berikut adalah beberapa rekomendasi untuk melindungi privasi dan keamanan data wajah pengguna.

5.1. Peningkatan Kesadaran Pengguna

Salah satu langkah pertama yang harus diambil adalah meningkatkan kesadaran pengguna mengenai risiko yang terkait dengan pengunggahan gambar wajah mereka ke aplikasi berbasis AI. Pengguna harus diberikan informasi yang jelas mengenai bagaimana data mereka akan digunakan, disimpan, dan dilindungi. Ini termasuk menjelaskan secara terbuka apakah data mereka akan digunakan untuk melatih algoritma, dijual ke pihak ketiga, atau disimpan dalam waktu yang lama.

Pendidikan yang lebih baik mengenai risiko privasi dan keamanan data biometrik sangat penting agar pengguna dapat membuat keputusan yang lebih sadar tentang aplikasi yang mereka gunakan. Pengguna juga perlu diajak untuk lebih kritis terhadap syarat dan ketentuan yang diberikan oleh aplikasi, memastikan bahwa mereka memahami dan menyetujui kebijakan yang ada sebelum mengunggah foto wajah mereka (Zhao et al., 2020).

5.2. Penggunaan Enkripsi dan Keamanan Data yang Kuat

Untuk memastikan bahwa data biometrik yang diunggah ke aplikasi tetap aman, pengembang aplikasi harus menerapkan teknologi enkripsi yang kuat. Enkripsi end-to-end harus diterapkan pada gambar wajah yang diunggah untuk mencegah akses oleh pihak yang tidak berwenang, baik selama proses pengunggahan, penyimpanan, maupun transmisi data.

Selain itu, aplikasi harus memastikan bahwa server tempat data wajah disimpan dilindungi dengan langkah-langkah keamanan yang memadai, seperti penggunaan firewall, pengujian penetrasi, dan protokol keamanan yang terkini untuk melawan potensi serangan siber. Pengembang aplikasi juga harus mematuhi standar keamanan yang telah ditetapkan oleh regulasi, seperti General Data Protection Regulation (GDPR) di Eropa atau peraturan perlindungan data lainnya di berbagai negara (Goodfellow et al., 2014).

5.3. Pengelolaan Data dan Penghapusan Secara Berkala

Aplikasi yang mengumpulkan data wajah pengguna harus memiliki kebijakan yang jelas tentang pengelolaan data dan penghapusan data setelah penggunaan. Setiap gambar wajah yang diunggah harus dihapus dari server setelah manipulasi selesai dan tidak boleh disimpan tanpa batas waktu, kecuali ada persetujuan eksplisit dari pengguna untuk penyimpanan lebih lanjut.

Penyimpanan data dalam jangka panjang harus dibatasi dan hanya dilakukan jika memang diperlukan untuk tujuan yang sah, misalnya untuk meningkatkan layanan AI dengan persetujuan pengguna. Selain itu, jika data wajah digunakan untuk pelatihan model AI, model tersebut harus dilatih dengan data anonim atau data yang tidak dapat dilacak kembali ke individu yang bersangkutan untuk menjaga privasi pengguna (Kietzmann et al., 2018).

5.4. Regulasi yang Lebih Ketat dan Standar Etika

Pemerintah dan badan regulasi perlu bekerja sama dengan industri untuk menciptakan kebijakan yang lebih ketat mengenai penggunaan data biometrik. Perlindungan yang lebih kuat terhadap data wajah pengguna harus diperkenalkan, dengan memberikan sanksi bagi perusahaan yang tidak memenuhi standar keamanan dan privasi yang telah ditetapkan. Regulasi data biometrik, seperti GDPR, harus diimplementasikan secara global untuk memastikan bahwa data pribadi pengguna dilindungi dengan baik.

Selain itu, pengembang aplikasi dan perusahaan yang menyediakan layanan manipulasi citra wajah berbasis AI harus mematuhi standar etika yang ketat. Misalnya, mereka harus memastikan bahwa teknologi ini tidak disalahgunakan untuk membuat deepfake atau konten yang dapat merusak reputasi atau integritas seseorang. Penerapan pedoman etika yang ketat akan membantu memastikan bahwa teknologi AI digunakan dengan cara yang bertanggung jawab dan tidak menimbulkan kerugian bagi masyarakat (LeCun et al., 2015).

5.5. Pengawasan dan Transparansi yang Lebih Baik

Aplikasi manipulasi citra wajah berbasis AI perlu meningkatkan transparansi dalam operasional mereka. Pengguna harus tahu di mana data mereka disimpan, siapa yang dapat mengaksesnya, dan bagaimana data tersebut diproses. Pengawasan yang lebih ketat juga diperlukan untuk memastikan bahwa aplikasi tidak melanggar privasi pengguna.

Salah satu langkah yang dapat diambil adalah dengan menyediakan audit data secara berkala oleh pihak ketiga yang independen untuk memastikan bahwa kebijakan privasi dan pengelolaan data yang diterapkan sesuai dengan standar hukum dan etika. Pengawasan ini dapat mengurangi potensi penyalahgunaan teknologi dan memberikan rasa aman bagi pengguna bahwa data mereka tidak akan disalahgunakan (Zhao et al., 2020).

6. Kesimpulan

Penggunaan teknologi AI dalam manipulasi citra wajah memberikan banyak manfaat dalam hal hiburan dan kreativitas, namun juga membawa risiko serius terkait dengan privasi dan keamanan data. Oleh karena itu, sangat penting untuk meningkatkan kesadaran pengguna, memperkuat kebijakan pengelolaan data, dan memastikan adanya regulasi yang memadai untuk melindungi data biometrik. Dengan langkah-langkah ini, kita dapat meminimalkan potensi risiko dan memanfaatkan teknologi AI dengan cara yang aman dan etis.

Daftar Pustaka

- Goodfellow, I., Pouget-Abadie, J., Mirza, M., Xu, B., Warde-Farley, D., Ozair, S., … & Bengio, Y. (2014). Generative adversarial nets. Advances in Neural Information Processing Systems, 27.

- Guan, Z., Zhang, C., & Liu, X. (2020). Deep learning and computer vision in facial recognition and manipulation. Journal of Artificial Intelligence Research, 67, 125-141.

- Kietzmann, J. H., Paschen, J., & Treen, E. (2018). Artificial intelligence in social media: A critical review and research agenda. Business Horizons, 61(3), 289-297.

- Zhao, Z., Li, S., & Chen, J. (2020). Privacy risks in biometric authentication: An emerging concern. Journal of Cybersecurity, 7(4), 62-79.